Serie: Künstliche Intelligenz: Wie können wir Maschinen Moral beibringen?

Ethik im Straßenverkehr: Wie man Maschinen Moral beibringt.

Eine künstliche Intelligenz steuert eine Fabrik, in der Büroklammern hergestellt werden. Programmierer haben ihr das Ziel vorgegeben, so viele Büroklammern wie möglich zu produzieren. Und damit ist der Teufel aus der Flasche: Die Software schreibt sich selbst um, wird immer cleverer, um immer bessere Produktionsmethoden zu ersinnen. Bald baut sie neue Maschinen, verarbeitet jede greifbare Materie, tötet Menschen – und verwandelt den Planeten in eine Büroklammerwüste.

Noch ist die Apokalypse aus Algorithmen nur ein Gedankenspiel, ersonnen vom Philosophen Nick Bostrom an der Universität Oxford. Aber die Geschichte macht auf ein Problem aufmerksam, das zunehmend auch Manager, Programmierer und Produktentwickler beschäftigt: Künstliche Intelligenz hat sich technisch enorm entwickelt, sie steuert Autos, therapiert Patienten, verkauft Produkte, nur einen ethischen Kompass haben die schlauen Maschinen bisher nicht.

Was das anrichten kann, zeigten erste Skandale aus dem vergangenen Jahr: Microsofts Chatbot Tay schwärmte auf Twitter plötzlich von Hitler und der Judenverfolgung. K5, ein Sicherheitsroboter vom US-Start-up Knightscope, bretterte in einem kalifornischen Einkaufszentrum ein Kind um. Die Ausrichter des Schönheitswettbewerbs Beauty AI wiederum mussten sich Rassismus vorwerfen lassen, weil ihre Maschinen-Jury nur Weiße zu Gewinnern kürte.

Derlei programmierte Patzer vergiften langfristig das Klima einer Gesellschaft – und entscheiden auch direkt über Leben und Tod, etwa wenn Roboter in den Krieg ziehen. Ähnlich wie Philosoph Bostrom warnen inzwischen auch der Physiker Stephen Hawking und Tesla-Chef Elon Musk vor superintelligenten Maschinen, die die Menschheit ausradieren. Zusammen mit mehr als 8000 Experten unterzeichneten sie schon vor zwei Jahren einen offenen Brief, den US-Forscher verfasst hatten, um vor den Gefahren der schlauen Software zu warnen. Tenor: Die Forschung müsse sicherstellen, dass künstliche Intelligenz der Gesellschaft nütze.

Killer-Kodex für Drohnen

„Wenn Programmierer künstliche Intelligenz entwickeln, kann das Hunderte Millionen Menschen betreffen“, sagt die britische Ethik-Beraterin Susan Liautaud, die an der kalifornischen Stanford-Universität Unternehmensethik lehrt. „IT-Unternehmen müssen sich darum heute über die langfristigen Folgen ihrer intelligenten Maschinen Gedanken machen“, sagt die Wissenschaftlerin. Dabei sollten sie NGOs und Politiker, Wissenschaftler und Nutzer an einen Tisch bringen.

Genau zu diesem Zweck haben Amazon, Google, Microsoft, Facebook und IBM eine Initiative namens Partnership on AI gegründet. Tesla-Chef Musk wiederum will mit seinem Projekt Open AI die Entwicklung von menschenfreundlicher KI voranbringen. Und Google hat ein eigenes Ethik-Board eingerichtet, um die Folgen von KI für die Gesellschaft zu bestimmen.

Aber lässt sich Ethik in die Sprache von Maschinen übersetzen? Kann man Moral programmieren, oder müssen Roboter sie lernen wie Menschenkinder? Und welchen Werten sollen Chatbots, selbstfahrende Autos und Haushaltsroboter überhaupt folgen?

Ronald Arkin ist einer, der ans programmierte Gute glaubt. Der Wissenschaftler am Georgia Institute of Technology in Atlanta arbeitet an einer Software, die Kriegsmaschinen Ethik eintrichtern soll. Damit etwa militärische Drohnen sich künftig an internationale Gesetze halten, wenn sie in den Kampf ausschwärmen. Terroristen abschießen: ja. Krankenhäuser und Wohnhäuser bombardieren: nein.

Moral als Code, das bedeutet, dass die Maschinen, einmal programmiert, klaren Regeln folgen. Etwa den Robotergesetzen des Schriftstellers Isaac Asimov, die unter anderem vorschreiben, dass Maschinen Menschen nicht schaden dürfen. Oder der Ethik des Utilitarismus, die das Wohlergehen aller Betroffenen maximieren will.

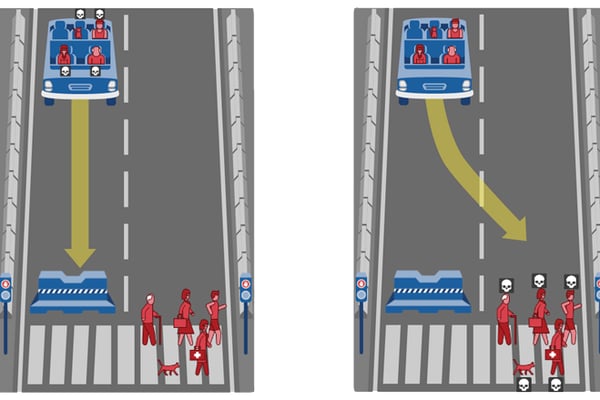

Wahl der Qual Soll ein selbstfahrendes Auto, dessen Bremsen versagen, auf die Betonwand zurasen und vier erwachsene Passagiere töten? Oder soll es ausweichen und drei Passanten töten, darunter ein Kleinkind? Beeinflusst die rote Fußgänger-Ampel die Antwort? Auf der Webseite moralmachine.mit.edu können Nutzer entscheiden.

Das Problem liegt im Detail: Im Einzelfall geraten Roboter, genau wie Sterbliche, schnell in ein moralisches Dilemma. Etwa, wenn sie zwei Menschen gleichzeitig davor bewahren müssen, in ein Loch zu fallen. Alan Winfield, Roboteringenieur am Bristol Robotics Laboratory in Großbritannien, simulierte dieses Szenario im Labor mit drei handtellergroßen Robotern. Ergebnis: In der Hälfte der Fälle konnte der Helfer-Bot sich nicht entscheiden, wen seiner Kumpanen er zuerst retten sollte – und ließ beide ins Unglück stürzen.

Industrie

Schon heute werden viele Arbeitsschritte von Maschinen übernommen - doch die vernetzte Produktion setzt auch in den Werkshallen eine weitere Automatisierungswelle in Gang. Das muss unterm Strich aber nicht zwangsläufig zu Jobverlusten führen, heißt es aus der Wirtschaft: Bereits Ende 2016 lag Deutschland bei der „Roboter-Dichte“ weltweit auf Platz drei hinter Südkorea und Japan - und trotzdem sei die Beschäftigung auf einem Rekordstand, erklärt der Maschinenbau-Verband VDMA. Auch der Präsident des Elektronik-Branchenverbandes ZVEI, Michael Ziesemer, sagt: „Es können auch mehr Jobs entstehen als wegfallen.“ Die Digitalisierung werde eine Vielzahl neuer Geschäftsmodelle und damit neue Stellen hervorbringen. „Wer kreativ ist, rangeht und sich Dinge überlegt, hat jede Menge Chancen.“

Transport und Logistik

Vor allem das vernetzte und automatisierte Fahren dürfte künftig viele Jobs überflüssig machen. „In der Zukunft wird es keine Lokführer mehr geben, vielleicht auch keine Taxifahrer und Lkw-Fahrer mehr“, glaubt etwa Bayerns DGB-Chef Matthias Jena. Studien prognostizieren Ähnliches: Bereits in zehn Jahren könnte jeder dritte in Europa verkaufte Lastwagen etwa auf der Autobahn automatisiert fahren, erwartet etwa die Beratungsfirma McKinsey. Im Gegenzug könnten rund um die Roboter-Autos und -Lkw aber auch neue Service-Dienstleistungen entstehen.

Büro

Schreibarbeiten, Auftragsabwicklung und Abrechnungen - Büro- und kaufmännische Fachkräfte erledigen nach Experteneinschätzungen Arbeiten, die heute schon zu einem hohen Grad automatisierbar sind. Dadurch könnten auch viele Arbeitsplätze auf dem Spiel stehen: Mehr als 1,6 Millionen Menschen in Deutschland sind in solchen Berufen tätig.

Verkäufer und Kassierer

Der Handel wurde als eine der ersten Branchen von der Digitalisierung erfasst - entsprechend laufen im Online-Handel viele Prozesse automatisiert ab. In stationären Läden aber sitzen meist noch Menschen an den Kassen, obwohl sich auch das Bezahlen automatisch regeln lässt. Das macht auch der Versandriese Amazon vor: In den USA testet er einen Supermarkt ohne klassisches Kassensystem und Verkaufspersonal - abgerechnet wird per Smartphone-App und Kundenkonto.

Landwirtschaft

Sie melken die Kühe, füttern, misten aus und helfen beim Ernten - Roboter haben längst auch auf den Bauernhöfen Einzug gehalten. Wo bisher meist viel Arbeit von wenigen Händen erledigt werden musste, sind maschinelle Kollegen eine willkommene Unterstützung. Ausschließlich maschinell wird aber auch der Bauernhof der Zukunft mit seinen vielfältigen Tätigkeiten wohl nicht funktionieren.

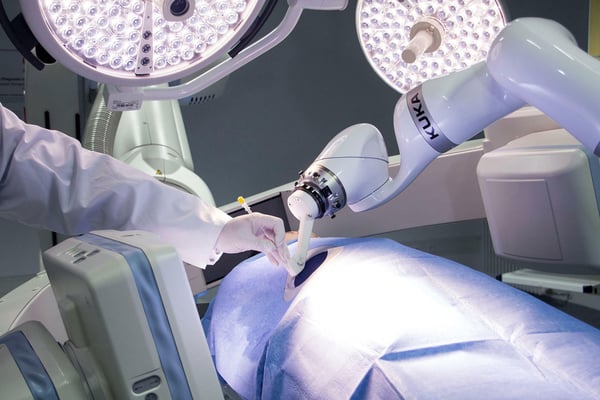

Krankenhaus und Altenheim

Roboter in der Pflege - was in Japan bereits zum Alltag gehört, bereitet vielen Menschen in Deutschland noch eher Unbehagen. Doch weil das menschliche Personal knapp ist, könnten Roboter auch hierzulande zur wichtigen Stütze werden. Im Einsatz sind sie teils schon heute bei der Essensverteilung oder beim Transport von Wäsche und Sterilgut - und als präzise Helfer am OP-Tisch.

Reinigungsdienste

Auch im Haushalt tun Roboter schon ihren Dienst, und neue Anwendungen dürften mit dem vernetzten Zuhause hinzukommen. Der Welt-Roboter-Verband IFR erwartet, dass von 2016 bis 2019 weltweit insgesamt rund 31 Millionen Roboter verkauft werden, die beim Rasenmähen, Staubsaugen oder Fensterputzen helfen. Assistenzroboter für Menschen mit Behinderung sind da noch nicht eingerechnet. Die Haushaltshilfe aus Fleisch und Blut aber werden sie nach Einschätzung des Heidelberger Instituts für Trend- und Zukunftsforschung nicht vollständig ersetzen. Manche Hausarbeit kann von Menschen einfach besser und schneller erledigt werden, und der Hilfsbedarf in der alternden Gesellschaft bleibt groß.

Lehrer und Erzieher

E-Learning gibt es zwar längst. Doch in Kindergarten, Schule oder Ausbildung geht es um mehr als um das reine Vermitteln von Stoff. Überall da, wo Sozialkompetenz, pädagogisches Wissen und Empathie gefragt sind, werden Roboter zumindest auf absehbare Zeit kaum mit dem Menschen mithalten können, ist Katharina Dengler vom Nürnberger Institut für Arbeitsmarkt- und Berufsforschung überzeugt.

Anwälte, Ingenieure und akademische Berufe

Zwar dürften solche Berufe angesichts von Spezialisierungsgrad und Komplexität weniger stark der Automatisierung ausgesetzt sein. In Teilbereichen wird künstliche Intelligenz aber durchaus eine Rolle spielen, wenn es etwa um die Prüfung großer Vertragswerke geht. Tendenziell schütze eine akademische Ausbildung besser davor, ersetzt zu werden, sagt IAB-Expertin Dengler.

Selbstfahrende Autos können sich derlei Zögern nicht erlauben. Wenn etwa die Bremsen versagen, muss die Software blitzschnell wählen, wen sie töten soll: Insassen oder Spaziergänger? Kinder oder Alte? Drei Hunde oder einen Menschen? Auf ihrer Webseite Moral Machine lassen Forscher des Massachusetts Institute of Technology (MIT) Millionen Nutzer solche Szenarien durchspielen. „Wir sehen regionale Muster“, sagt Projektleiter Sohan Dsouza. Menschen aus Asien neigten dazu, das Leben der Passagiere zu schützen – auf Kosten der Fußgänger. Menschen aus westlichen Ländern tendierten dagegen dazu, so viele Leben wie möglich zu retten.

Computer schmökert Kinderbücher

Moral ist offenbar relativ, je nach Herkunft, Alter oder Situation. Manche Forscher wollen Roboter darum nicht mit einem festen Ethik-Kodex ausstatten. Stattdessen sollen sich Maschinen moralisches Verhalten von Menschen in ihrer Umgebung abschauen. So sieht das auch Jen-Hsun Huang, Gründer und CEO des US-Chipherstellers Nvidia, der unter anderem Autos mit künstlicher Intelligenz ausstattet. „Intelligente Maschinen sind wie Kinder: Sie können lernen, Gutes wie auch Böses zu tun“, sagt Huang. „Wir sollten künstliche Intelligenz zum Guten erziehen“, wünscht er sich, „so wie wir unseren Kindern gute Vorbilder bieten, ihnen Werte anerziehen und Toleranz für verschiedene Kulturen vermitteln.“

Die Forscher Mark Riedl und Brent Harrison vom Georgia Institute of Technology etwa lassen dazu intelligente Software Kinderbücher schmökern. Die künstliche Intelligenz soll aus den Geschichten Schlüsse ziehen, welches Verhalten gut und welches schlecht ist.

Das Problem daran: Künstliche Intelligenz kann mit den falschen Lerndaten auch unmoralisches Verhalten lernen – wie ein Kind, das in einem Problemviertel aufwächst. Obendrein ist KI-Software oft so komplex, dass selbst ihre Programmierer nicht mehr nachvollziehen können, wie sie zu ihren Schlüssen gekommen ist.

Das indes ist nicht nur ein Problem der Roboter: Wenn Menschen in Unfällen reflexartig reagieren, können sie oft hinterher nicht erklären, warum sie wie gehandelt haben. Und oft genug pflegen wir eine Doppelmoral: In einer Science-Studie stimmten 76 Prozent der Befragten zu, dass ein selbstfahrendes Auto lieber den Passagier töten sollte als zehn Passanten. Ein solches Auto kaufen wollte aber kaum einer der Befragten.

Vielleicht sind Maschinen eines Tages doch die konsequenteren Ethiker auf dem Planeten. Aber was, wenn nicht? Wie verhindern, dass superintelligente Maschinen die Welt in Büroklammern verwandeln? Google-Ingenieure haben dazu vor ein paar Monaten eine Lösung vorgeschlagen, eine Art Notausknopf für Roboter: Dreht die künstliche Intelligenz durch, dann schlägt die programmierte Moralkeule zu.