Künstliche Intelligenz: Roboter erklimmen die nächste Stufe

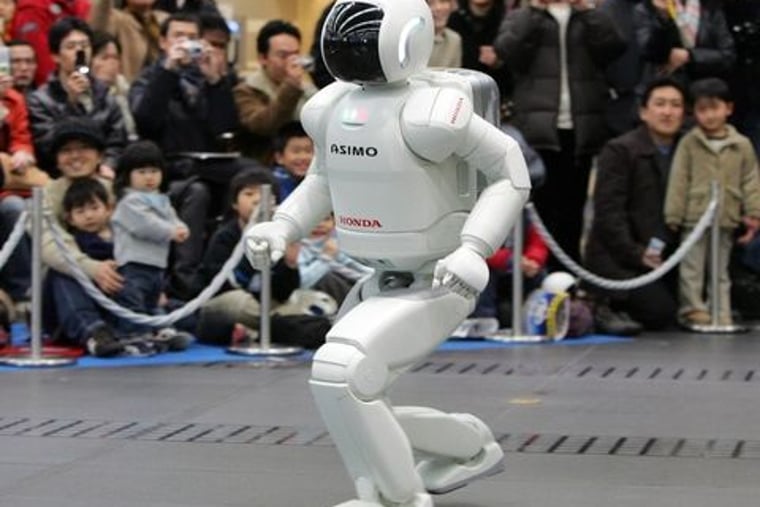

Hondas Roboter "Asimo"

Der Traum jeder Studenten-WG ist schlank gebaut, hat metallisch schimmernde Haut, zwei Hände aus Aluminium und sechs Augen: Die Rede ist nicht von einer Mutation der Cyberbraut Blu aus dem Saturn-Werbespot, sondern von Marvin. Einem Roboter. Auf Zuruf holt Marvin Bier aus dem Kühlschrank, bringt ohne Murren Socken zum Wäschekorb und reinigt bei Bedarf den Tisch. Das Beste aber: Spätestens 2013 soll das von Forschern der Universität Freiburg programmierte Maschinenwesen nach einer krachenden Party sogar Zimmer aufräumen können.

Gegenstände zu sehen ist für den Roboter dank 3-D-Kameras und Laser-scanner schon jetzt kein Problem mehr. Sogar Farbe und Textur von Objekten nimmt Marvin wahr, der seinen Namen einem Roboter aus dem Film "Per Anhalter durch die Galaxis" verdankt. Doch Bilder nur wahrzunehmen reicht nicht. Er muss auch verstehen können, was er sieht.

Marvin sammelt Erfahrungen

Dafür bringen der Freiburger Wissenschaftler Wolfram Burgard und sein Team ihm gerade unter anderem bei, was Schmutz ist. Dafür nutzen sie den sogenannten Kaffeebohnen-Trick und schicken Marvin mit einem Staubsauger in der Hand zu einem Tisch: Saugt er Bohnen auf und das Aussehen der Tischplatte ändert sich, weiß Marvin, es ist Schmutz. Ändert sich nichts, heißt das: Die Platte ist sauber. Das Bild der Bohnen speichert er und beseitigt sie beim nächsten Putz gezielt.

Mithilfe solcher Erfahrungen entwickelt Marvin eine Strategie, um auch den Fußboden effizient zu reinigen. Daran scheiterten Roboter bislang in der Regel.

Nun aber lernen sie, Erfahrungen zu sammeln und daraus zu lernen. In Forschungszentren weltweit schärfen Informatiker, Kinematiker, Ingenieure und Elektrotechniker ihren Maschinenwesen die Sinne. Dass, so hoffen die Forscher, wird den Maschinen die Fähigkeit geben, autonom auf ihre Umwelt zu agieren.

Das wird nicht nur den Einsatz der Roboter im Haushalt und bei der Pflege revolutionieren, sondern auch ganz neue Einsatzszenarien der Maschinenwesen in Fabriken oder bei Naturkatastrophen ermöglichen. Dort beispielsweise sollen die angstfreien Retter gefährliche Bergungsmissionen übernehmen können.

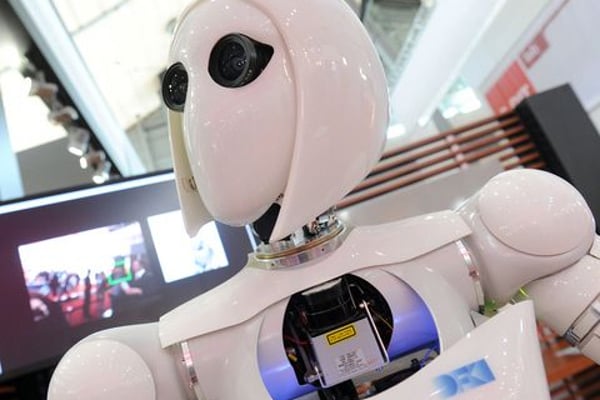

Der Roboter AILA auf dem Messegelände in Hannover.

Zahlreiche neue Entwicklungsansätze könnten das bald Wirklichkeit werden lassen. Einem Roboter vom Typ PR2 wie Marvin das Putzen beizubringen ist dafür exemplarisch: Um einen Raum zu säubern, muss er sich orientieren, Dinge erkennen – und auf Menschen reagieren. "Er muss", wie der Robotikforscher Andreas Birk von der Jacobs Universität Bremen sagt, "aus abstrakten Sensordaten ein Verständnis für seine Umwelt entwickeln."

Dabei sind Maschinenwesen auch ohne derlei Fähigkeiten jetzt schon aus dem Alltag nicht mehr wegzudenken: Weltweit arbeiten laut der Branchenvereinigung International Federation of Robotics (IFR) mehr als eine Million in Fabriken. Rund 1,5 Millionen werden jährlich in Form von automatischen Staubsaugern oder niedlich fiependen Spielzeug-Dinos verkauft.

30 Milliarden Umsatz bis 2015

Bis 2015 will die Robo-Branche, zu der Hersteller wie Kuka, iRobot und Mitsubi-shi gehören, 30 Milliarden Euro weltweit umsetzen. Vor allem in der Autoproduktion sind sie unverzichtbar – Daimler etwa setzt seit 1970 Montageautomaten ein.

Auf völlig selbstständige Maschinen, die Aufgaben erledigen, wie eine Wohnung aufzuräumen, warteten bislang nicht nur WG-Bewohner vergeblich. Selbst Asimo, der von Honda entwickelte Star unter den Maschinenwesen, kann zwar Geige spielen, joggen oder Treppen steigen. Doch sich ohne menschliche Hilfe auf eine andere Tritthöhe der Stufen einzustellen als zuvor programmiert, das vermag auch Asimo noch nicht.

Inzwischen aber machen die Forscher wichtige Fortschritte. Damit sie sich etwa in einem Raum zurechtfinden können, werden Roboter mit Landkarten oder Grundrissen gefüttert. Die Karten vergleichen sie mit Bildern und Messungen, die Kameraaugen und Entfernungssensoren liefern. So stellen sie ihren Standort fest.

Doch das ist erst der Anfang. Am Bremer Standort des Deutschen Forschungszentrums für Künstliche Intelligenz (DFKI) wollen die Forscher ihren Maschinen beibringen, sich ohne Hilfe zu orientieren. Als Testparcours dient ihnen eine Halle mit nachgebauter Mondlandschaft: Ein vier Meter hoher Krater erhebt sich in der Mitte, rundum liegt Geröll. "Im Weltall gibt es weder GPS noch Karten", sagt Jakob Schwendner, der das Projekt Intelligente Mobilität am DFKI leitet. Sein Kalkül: Wer sich auf dem Mond zurechtfindet, schafft das auch an jedem Ort der Erde.

Ihrem Spinnenroboter Spaceclimber brachten die Entwickler in der Mondhalle schon bei, in den Krater zu kraxeln. Nachfolger Asguard soll nun lernen, sich nur mit Kameras und Laserscannern im unwegsamen Gelände zu orientieren. Dafür kann Asguard im Radius von zehn Metern ein Bild seiner Umgebung erstellen. Seinen Standort im Bild lokalisiert er mit Abstandsmessungen zu Hindernissen.

Zudem kann der Cyberscout seine Umgebung erfühlen. In seinen sternenförmigen Rädern und dem Körper sind Sensoren eingebaut, die Informationen über die Beschaffenheit des Bodens sammeln. Auf diese Weise erstellt er während seiner Erkundungstour eine Karte. Damit findet er auch zum Ausgangspunkt zurück.

Neben Missionen ins All ermöglicht die weltraumfähige Technik auch ganz irdische Einsätze. In Gebäuden gibt es kein GPS zur Navigation, im Dunkeln sind auch Roboter blind. Funkkontakt für die Steuerung ist, wie im havarierten AKW Fukushima, nicht immer vorhanden. Asguard, so die Idee, könnte, auf sich gestellt, durch die Ruine kurven und die Strahlung messen. Dasselbe gilt für Trümmerlandschaften, in deren Chaos er Menschen mit der Umrisserkennung seiner Kameras lokalisieren kann. Deren Position wird gespeichert und an Rettungstrupps weitergeben.

Rollender Langhaarrasierer

Weniger apokalyptisch, doch ebenso nützlich sind die Szenarien, in denen sich der Care-O-bot des Fraunhofer-Instituts für Produktionstechnik und Automatisierung (IPA) bewegt. Er arbeitet wie ein mechanischer Butler in einem Altenheim in Stuttgart. Äußerlich erinnert das Maschinenwesen an einen überdimensionierten, rollenden Langhaarrasierer mit Greifarm. In ihrer Jugend hätten ihn die Senioren wohl für einen Außerirdischen gehalten.

Im ersten Schritt fungiert der Care-O-bot als Kellner, der den Heimbewohnern auf Wunsch Getränke an den Tisch holt und dabei autonom zwischen Aufenthaltsraum, Zimmern und Küche pendelt – ohne dabei Rentner, Personal oder Möbel über den Haufen zu fahren. In einem nächsten Entwicklungsschritt, soll er auch die Bewohner erkennen und die passenden Medikamente ausliefern lernen.

Der Care-O-bot ist das Ergebnis von mehr als zehn Jahren Forschungsarbeit der Informatikerin Birgit Graf und ihrem IPA-Team. Seine Fähigkeiten verdankt der Heimroboter beharrlicher Programmierarbeit sowie unzähligen Tests in einer Modell-Wohnung. Und einer Technik aus der Unterhaltungselektronik.

Denn im Care-O-bot steckt unter anderem der 3-D-Sensor Kinect, den der Softwarekonzern Microsoft für seine Videospiel-Konsole XBox entwickelte. Normalerweise registriert der Sensor Körperbewegungen von Daddelfans, die so Computerspiele steuern – etwa beim Tennismatch gegen virtuelle Gegner. Im Altenheim hilft der Videosensor dem Roboter, blitzschnell und haargenau menschliche Umrisse und Gegenstände zu erkennen.

Noch einen Vorteil hat das Gaming-Auge: Statt 4000 Euro, wie ältere Modelle, kostet der Sensor nur 100 Euro. Auf einen solchen Preissturz hofft Entwicklerin Graf auch bei anderen Bauteilen. Die ersten drei handgefertigten Roboter kosteten noch 250 000 Euro – pro Stück.

Dafür sind die Prototypen vergleichsweise intelligente Gesellen. Sie glänzen nicht nur durch ihre ausgeprägte Wahrnehmung der Umgebung. Sie sind auch lernfähig: Neue Bewegungen für den Greifer merken sie sich, wenn ein Mensch ihnen die Hand führt. Und Cola light unterscheidet der Roboter fortan von zuckerhaltiger Limonade, wenn man ihm vorher die unterschiedlichen Dosen zeigt.

Mit Menschen kann auch Frida – wenn auch auf ganz andere Weise. Die Dame mit den knubbeligen Armen soll der erste humanoide Roboter sein, der in Fabriken neben seinen Vorbildern aus Fleisch und Blut werkelt. Bislang dürfen die Maschinen nur hinter Sicherheitszäunen in der Nähe von Menschen arbeiten. Zu groß ist die Gefahr, das sie mit ihren Elektroarmen menschliche Kollegen erschlagen.

Roboter-Kommunikation

Frida dagegen ist so gepolstert, dass sie niemanden verletzt. Rumpelt ein Mensch mit ihr zusammen, schaltet sie sich ab. Entwickelt wurde die digitale Monteurin von Forschern des Schweizer Elektrotechnikkonzerns ABB für die Montage von Handys und Computern.

"Bei der Entwicklung stand im Vordergrund, dass Frida flexibel einsetzbar ist", sagt Sönke Kock, Leiter des globalen Mechatronikprogramms von ABB. Deshalb wiegt sie nur knapp 30 Kilo und lässt sich problemlos von Montagetisch zu Montagetisch hieven. Zurzeit ist der Werkstatt-Bot bei mehreren Unternehmen im Test, die aber nicht genannt werden wollen.

Noch sind Fridas Sinne aus Kostengründen auf das Nötigste beschränkt. Sie erkennt gerade mal die Form von Bauteilen wie Leiterplatten, die sie mit ihren Greifern verklebt. Aber in einem Projekt mit fünf europäischen Forschungsinstituten und dem Softwareentwickler Dynamore wollen die ABB-Techniker der knuffigen Malocherin beibringen, mit ihren Sensoren Arbeitstechniken zu prüfen und sie automatisch zu verbessern. Die Ergebnisse kann Frida über WLAN mit ihren Genossinnen teilen. So wird sich das mechanische Kollektiv blitzschnell in neue Arbeitssituationen einarbeiten können.

Aber nicht nur das Lernen und die Fähigkeit, mit Menschen in unterschiedlichen Umgebungen zu arbeiten, bringen Forschern den Maschinen zurzeit bei. Roboter können auch harte von weichen Gegenständen unterscheiden.

Bisher waren alle Maschinenhände mit feiner Sensorik, wie die des US-Roboters Domo, hochempfindlich: Zwar kann Domo eine reife Banane greifen, ohne sie zu quetschen. Reißt man ihm die Frucht aus der Hand, wird sie beschädigt. Diese Lücke schließt die neueste Entwicklung aus der Roboterschmiede beim Deutschen Zentrum für Luft- und Raumfahrt (DLR): eine Metallhand, die einen reifen Apfel zerdrücken kann und sensibel genug ist, eine reife Tomate zu ernten. Kombiniert mit einem Roboter könnte sie Früchte pflücken oder Verschüttete ausgraben.

Terminator-Assoziationen weckt nicht nur ihr Aussehen. Im Test schlug ein Forscher mit einem Hammer auf die Kreation ein. Die Hand blieb heil und hätte ihrem Peinigern problemlos den Mittelfinger zeigen können. Die Stabilität ermöglichen Kunststoff-Sehnen, die den Fingern erlauben, bei Schlägen nachzugeben.

Die Königsdisziplin der maschinellen Sinnsuche aber ist die Kommunikation: Zwar haben Wissenschaftler der Universität Bonn ihrem Roboter Cosero schon beigebracht, menschliche Gesten zu deuten. Aber an einer wirklich menschenähnlichen Unterhaltung, über reine Spracherkennung hinaus, sind diesseits der Leinwand bisher alle Maschinen gescheitert.

Robuster Terminator-Griff

Ein Forscherteam an der Technischen Universität München (TUM) will seinem Roboter Iuro genau das beibringen. Spätestens 2013 soll er ohne Karten, nur durch Befragen und Verstehen von Passanten, die 1,5 Kilometer von der Universität zum Marienplatz im Zentrum finden.

Schon 2008 schickten die TUM-Forscher ihren Roboter Ace auf die Reise. Kommunizieren konnte er hauptsächlich via Touchpad. Auch dem Charme seines Äußeren konnte er nicht vertrauen. Der Stadtentdecker ähnelte einem Container der Kleiderspende auf zwei Rädern.

Iuro, der Neue, hat im Vergleich zu seinem Vorgänger nicht nur ein richtiges Gesicht mit Schwulstlippen und Glupschaugen, mit denen er lächeln und zwinkern kann. Er sieht auch besser. "Man kann sich seine Wahrnehmung ungefähr so vorstellen wie eine Reise – Bild für Bild – durch Google-Street-View", beschreibt Kolja Kühnlenz, einer der Leiter des Projekts, die Fähigkeit seiner Pfadfindermaschine. Außerdem soll er Ampeln und Straßenschilder erkennen.

Die größte Weiterentwicklung gegenüber Ace wird aber eine Sprachsoftware sein. Mit der soll Iuro Passanten nach dem Weg fragen und ihre Antworten verstehen.

Ist Iuro erfolgreich, könnten Roboter bald nicht nur – wie Marvin – schmutzige Zimmer putzen, sondern auf dem Marienplatz auch schmutzige Witze erzählen.